这个文章主要是一个实验分析的工作,文章没有提出新的方法,但是提出了一个假设:激光雷达强度图像可以用于VPR,然后通过目前现有方法的融合证明了这个假设的可行性。在该假设成立的前提下,激光视觉融合或许可以有新的思路.

本篇论文解读已投稿至3D视觉工坊,记录在个人博客仅供个人学习记录,商业转载行为请联系3D视觉工坊公众号

《Globally Consistent and Tightly Coupled 3D LiDAR Inertial Mapping》(ICRA 2022)

Motivation

VPR(Visual place recognition)是一个常见的任务,但是从来没有方法将点云强度构成的图像应用到VPR方法上,考虑到圆柱投影后的点云强度图的密集性,作者认为这个思路是可行的。所以在这个工作中作者分析了VPR如何与 LiDAR 数据结合使用,并对不同的数据集进行了评估。结果表明,这种方法的确是可以确定闭环的有效方法。

Contribution

- 分析评估现有视觉位置识别技术在应用于 3D LiDAR 扫描仪的强度提示时的性能。

- 使用 3D LiDAR 在多个机器人数据集上测试了 VPR 方法的几种变体。实验表明,对现有 VPR 技术的直接调整可以产生可靠的回环,从而实现大规模的仅激光 LiDAR SLAM

Content

-

激光雷达

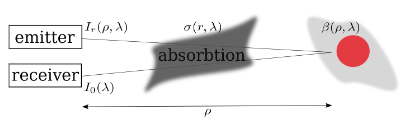

某种程度上,激光雷达强度是一个关于反射范围以及波长的函数:

测量信号第一次返回的时钟分辨率限制了距离测量的分辨率。然而,通过确定发射和接收信号之间的相位差可以获得额外的精度增益。单个检测也可能相当嘈杂。因此,以更高准确度为目标的扫描仪会发送多个脉冲。这反过来又限制了距离测量的频率。现在单个传感器的测量频率 fm 可能达到 50 kHz。通过选择光束的旋转频率fr,角分辨率直接为2πfm fr。机械方面的考虑限制了传感器的旋转速度。而在 2D 情况下,光束可以通过相对较小的旋转镜偏转,而在 3D 情况下,传感器头携带多个测量单元 - 目前多达 128 个。

扫描仪还测量测量强度,即从表面反射的光量。该强度信息被归一化并离散化为 8 或 16 位值。强度取决于表面特性,还有几个其他因素会影响测量。方程式中的所有项。 (1) 是连续的。因此,我们可以预期,当测量相同的 3D 点时,视点的轻微变化会产生强度的轻微变化。

之前针对 SLAM 和位置识别的 3D-LiDAR 的大部分工作都集中在使用范围测量上,而忽略了其他可能有价值的信息。这也可能是因为机器人技术中使用的旧扫描仪的强度信息没有那么大。最近的 3D-LiDAR 表现出更高的精度和垂直分辨率。当组装成全景图像时,强度会让人想起使用灰度相机获得的强度。毫无疑问,LiDAR 强度图像的质量与相机等无源传感器获取的图像相比仍然较低。然而,在机器人技术中,特别是在 VPR 任务中,3D-LiDAR 扫描生成的强度图像带来了诸如不受外部光照条件和阴影影响等优点。

自动驾驶和自动驾驶汽车的普及推动了 3D-LiDAR 的改进。在这个应用领域,它们的主要用途是提供局部 3D 重建和障碍物信息。传统上,使用 LiDAR 进行全局 3D 重建是闭环的重大挑战。与更具描述性的图像相比,这源于仅范围 3D 扫描之间较高的传感器混叠。文献中包含丰富的 3D-LiDAR 配准和映射算法,而该社区在位置识别等任务上投入的精力较少,这构成了有效闭环的基础。相比之下,计算机视觉社区在这个地点识别任务上投入了大量精力,取得了令人印象深刻的成果。因此,本文的目的是分析常见 VPR 方法在与 LiDAR 强度信息结合使用时的行为.

-

应用于圆柱形激光雷达强度图像的视觉位置识别(VPR)

这一部分主要介绍的是作者如何处理来自激光扫描的图像形成,然后回顾VPR的大致结构。

A. 图像形成

执行圆柱投影,将激光雷达点从笛卡尔坐标系转换成球坐标系:

\[\begin{array}{l} \rho=\sqrt{x^{2}+y^{2}+z^{2}} \\ \theta=\operatorname{atan} 2(y, x) \in[-\pi / 2, \pi / 2] \\ \phi=\operatorname{asin}(z / \rho) \in[-\pi, \pi] \end{array}\]假设光束均匀分布,可以计算 (u,v) 如下

\[\left(\begin{array}{l} u \\ v \end{array}\right)=\left(\begin{array}{c} \frac{W}{2}\left(1+\frac{\theta}{\pi}\right) \\ H \frac{f_{\text {up }}-\phi}{f_{\text {up }}-f_{\text {low }}} \end{array}\right)\\ W和H是图像的宽度和高度,f指的是Fov。\]如果多个点落在同一个图像像素中,则仅保留具有最近距离的值。在创建图像的每个像素中,存储强度值而不是距离。

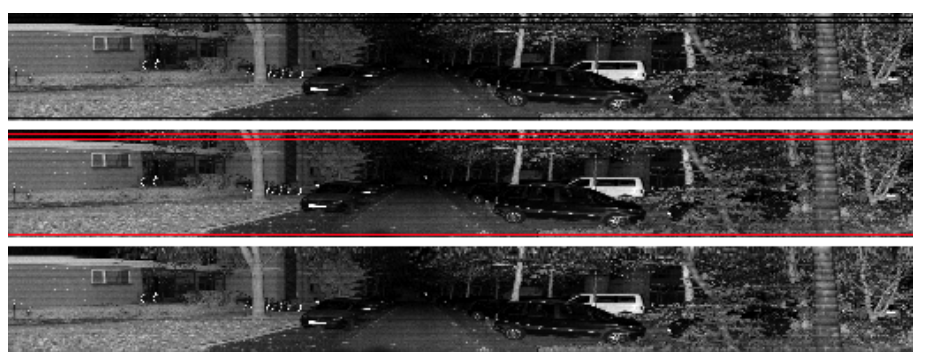

垂直光束的不均匀分布可能会导致生成的图像中出现空白,通常是整个水平行。这个问题可以通过缩小垂直分辨率或执行插值来后验解决。在本文的实验中,作者采用了第二种方法。为了从全景图像中删除空行,首先使用二进制阈值和与图像一样宽的水平内核来检测它们。然后通过双线性插值计算空行中每个像素的插值。下图显示了这个过程的结果

B.特征提取

分别实验测试了ORB,BRISK,SURF,Superpoints等方法,具体结果见实验部分。

C.VPR

作者在实验中测试的方法是基于树的HBST和基于词袋的DBoW2,具体结果见实验部分。

-

实验

实验主要有5个组合配置:

FAST - ORB - HBST

FAST - BRISK - HBST

FAST - ORB - DBoW2

Superpoint - DBoW2

FAST - SURF - DBoW2

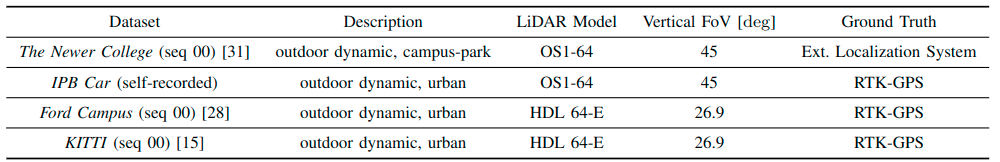

实验数据集配置如下:

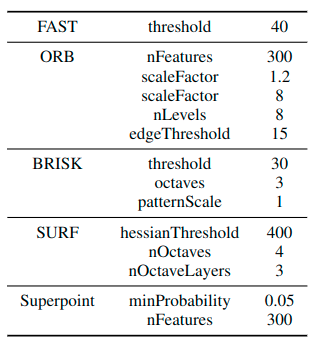

使用 FAST 作为关键点检测器,Superpoint 直接为所有实验输出成对的关键点和描述符。对于每个数据集,提取了以下描述符:ORB、BRISK 作为BIN,Superpoint 和 SURF 作为浮点。针对检索方法,使用 HBST 参数 δmax = 0.1 和 Nmax = 50 来获取BIN特征,详细参数如下:

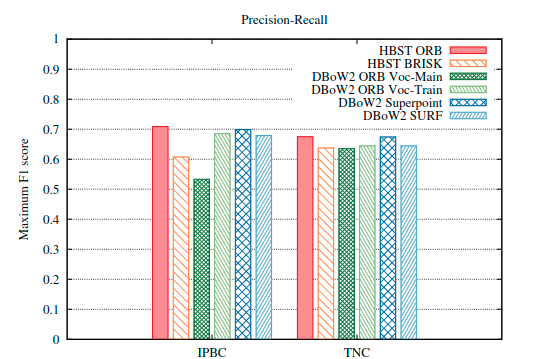

针对上述的五个配置,测试了F1指标,整体方法精度均可行:

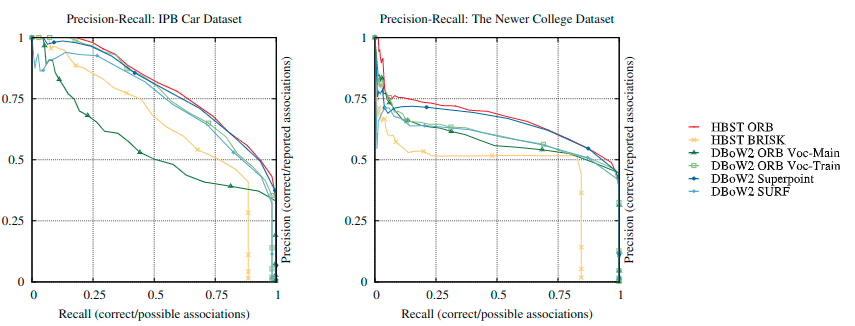

PR曲线指标测试如下:

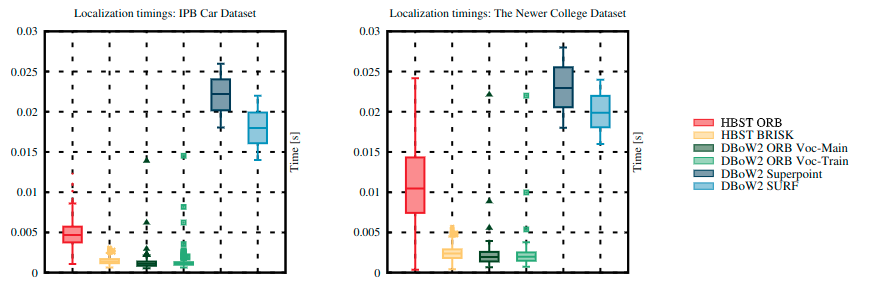

时间消耗如下:

总体来讲,在测试的方法之中,ORB 与 HBST 和 DBoW2 相结合的结果最佳。 Superpoint-DBoW2 组合的性能也不错。但是浮点描述符的计算成本也相对更高。在 The Newer College 数据集上的准确度不如在 IPB Car 的自记录数据集上获得的准确度。因为这些数据是在校园中行走时记录的,所以视点变化比较明显。

Conclusion

这篇文章的话,主要是一个实验分析的工作。首先作者提出了激光雷达强度图像可以用于VPR的假设,然后通过目前现有的方法分析了将激光雷达强度图像用于闭环的VPR的性能,实验在四个不同的数据集上进行了测试,实验结果表明了将激光雷达强度图像应用于VPR是非常可行的。虽然这篇文章没有提出新的方法,但是这份工作对于激光雷达和视觉的融合有比较大的启发意义,比如说激光视觉融合回环。