挺有意思的一份工作,跨模态视觉定位。

本篇论文解读已投稿至3D视觉工坊,记录在个人博客仅供个人学习记录,商业转载行为请联系3D视觉工坊公众号

《RGB2LIDAR: Towards Solving Large-Scale Cross-Modal Visual Localization》(ACM-MM 2020 )

Motivation

跨模态匹配是自动驾驶所需要的功能,目前现有的跨模态匹配定位存在一些问题,一是他们的数据集的体量很小并且精度不高,二是他们严重依赖于人工设计的特征所以无法保持在不同环境的鲁棒性,三是他们绝大部分在城市场景进行测试,场景单一。鉴于以上原因,作者认为目前的跨模态匹配方案是无法证明他们的有效性,所以一一针对这些问题给出了解决方案。

Contribution

- 本文研究了一个重要但很大程度上尚未探索的大规模跨模态视觉定位问题。并且目前现有的跨模态工作对于数据集的大小和场景限制多。作者认为本文的工作能对未来的跨模态视觉定位工作起到重要的启发作用。

- 作者认为本文提出了第一个基于深度学习的跨模态视觉定位方法,该方法基于训练联合的数据表示并且同时利用多模态的外观和语义信息。

- 为了对跨模态视觉定位任务进行大规模评估,本文引入了一个新的大规模数据集,其中包含 550K个跨模态耦合定位对,定位对包含地面RGB 图像和来自覆盖约 143 平方公里区域的航空 LIDAR 点云的渲染深度图像。

- 本文比较了两种用于训练LIDAR深度图的语义分割网络的互补方法,一种是基于 LIDAR 深度分割网络的弱监督训练,另一种是对有限多样性数据集进行全监督的训练。

- 本文进行了广泛的实验研究,以确定这个问题的挑战性,并展示了所提出的模型与以前的工作相比的优势。本文的最终模型在从 14 平方公里区域收集的 50K 位置对的大型测试集中匹配中位排名第5 。

Content

-

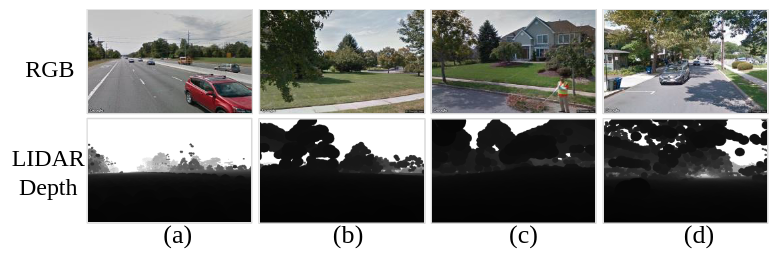

GRAL数据集

本文的贡献之一就是提供了一个大范围的跨模态匹配数据集,数据集采样如下,主要包含RGB图像和相应的LIDAR深度图信息。数据集总共包含557627个匹配对,其中20%作为验证集,10%作为测试集,剩下的作为训练集。RGB 图像从谷歌街景收集,LIDAR深度图通过 USGS 渲染航空 LIDAR 点云来收集。

-

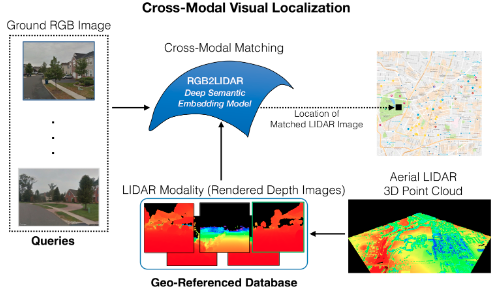

RGB2LIDAR

本文所提出的RGB2LIDAR框架如下,主要思路就是通过将地面 RGB 图像与LIDAR深度图进行匹配跨模态地理定位。在训练期间,提供从同一地理位置捕获的 RGB 图像和 LIDAR 深度图像的匹配对。在测试期间,执行跨模态检索,通过匹配RGB图像以及LIDAR深度图来查询 RGB 图像的地理位置。

具体内容依次如下,首先描述了一个基于使用外观信息学习联合多模态嵌入的跨模态匹配的通用框架;然后通过融合在外观和语义线索的不同组合上学习到的联合embedding以改进跨模态匹配的精确度;最后提出了两种互补的方式来从LIDAR深度图中提取语义信息。

A. 训练联合多模态embedding

基于目前比较流行的一些训练对,使用了三元组排序损失函数在一个embedding空间里embed两个损失函数。假设RGB图像和LIDAR深度图的特征向量分别是$f_r$和$f_d$,然后使用一个线性投影将两个模态都投影到一个共同空间,即$r_p=W^{(r)}f_r$和$d_p=W^{(d)}f_d$,$W^{(r)}$和$W^{(d)}$分别是RGB图像和LIDAR深度图的投影函数。

在已知RGB图像和LIDAR深度图的联合特征表示对的前提下,接下来的目标是使得来自相似地理位置的特征对的特征空间中的正负对比更接近。作者使用双向三元组排名损失函数来实现这个目标:

\[\begin{aligned} \mathcal{L}_{p} &=\max _{\hat{d}_{p}}\left[\Delta-S\left(\boldsymbol{r}_{p}, \boldsymbol{d}_{p}\right)+S\left(\boldsymbol{r}_{p}, \hat{d}_{p}\right)\right]_{+} \\ &+\max _{\hat{r}_{p}}\left[\Delta-S\left(\boldsymbol{r}_{p}, \boldsymbol{d}_{p}\right)+S\left(\hat{\boldsymbol{r}}_{p}, \boldsymbol{d}_{p}\right)\right]_{+} \end{aligned}\\ [x]_+=max(x,0),\mathcal{L}_p是正对(r_p,d_p)的损失,\hat{r_p}和\hat{d_p}分别是r_p和d_p的负样本\\ \Delta是损失的边界值,评分函数S(r_p ,d_p)是余弦相似度。\]B. 组合外观和语义的线索

为了有效地利用外观和语义信息,我们基于之前模型集构建检索系统 ,其中包含多个专家模型的组合从而获得高质量的预测器。通过使用4种不同的从RGB图像和LIDAR深度图获得的外观和语义特征的组合方式,来找出最合适的联合embedding模型。

在查询阶段,给定RGB图像,那么在每个联合embeding空间都与相应的LIDAR深度图计算一次相似度分数。最终的专家模型使用分数的加权融合进行最终排名:

\[\begin{aligned} S(\boldsymbol{r}, \boldsymbol{d})=\boldsymbol{w}_{1} S_{A p p-A p p}(\boldsymbol{r}, \boldsymbol{d})+\boldsymbol{w}_{2} \operatorname{S}_{A p p-S e m}(\boldsymbol{r}, \boldsymbol{d})+ \\ w_{3} S_{S e m-A p p}(\boldsymbol{r}, \boldsymbol{d})+w_{4} S_{S e m-S e m}(\boldsymbol{r}, \boldsymbol{d}) \end{aligned}\\\]App指的是appearence,Sem指的是semantic, $S_{app-Sem}$指的是使用来自RGB的外观和来自Lidar的语义,其他的以此类推, $w_1,w_2,w_3,w_4$分别是经验值。

总的来说,这里作者采用的是一种比较简单直接的融合方式,可能是因为作者仅仅是想证明融合多个线索比单个线索好,也就是说,这里存在很大的改进空间。

C. LIDAR深度图的语义线索

对于 RGB 模态,作者直接使用基于Seg-Net的预训练分割网络。鉴于当时并没有基于航空LIDAR点云的预训练分割网络,并且也很难在LIDAR深度图上获得人工的标注,另外在实验中也注意到如果直接利用在 RGB 图像上训练的特征来从 LIDAR 图像中提取语义线索,训练出的联合embedding的性能很差。

所以在这个部分,作者主要探索了如何采用两种互补的方式来提取激光语义特征:

I.弱的跨模态监督

这个方法受到两个简单直觉的启发:(1)虽然没有针对航空 LIDAR 深度图像的预训练分割网络,但存在强大的 RGB 图像分割网络,以及(2)RGB 和 LIDAR 深度图像是弱对齐的,因此 RGB 分割图包含有关捕获场景的总体布局的有用信息。

之后利用从配对 RGB 图像中提取的分割图作为地面实况图来训练 LIDAR 深度图的分割网络。由于模态之间的弱对齐,RGB 分割图包含足够丰富的信号来训练 LIDAR 深度图像的合理分割网络,

II.小数据集的全监督

第一种方法的一个缺点是RGB模态中的标注存在比较多的杂音,即使是有用的标注也仅仅是与LIDAR模态弱对齐,这可能会导致模型无法很好地泛化。所以探索了第二种方法,就是使用在其他数据集上训练分割网络来训练特征。实验中使用DublinCity 数据集,其中包含在都柏林市中心周围收集的标记 LIDAR 点云,面积仅为2KM$^2$。

作者之后在实验中介绍了如何使用这两种互补的方法来提供语义线索。

-

实验

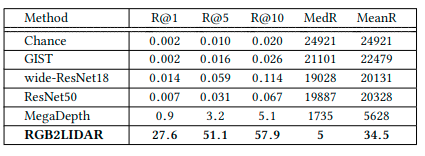

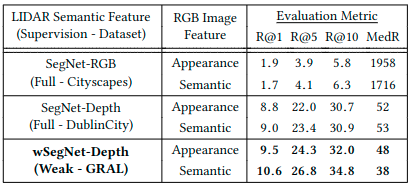

A.GRAL数据集的测试结果

可以很明显的看出,与现有的baseline相比,作者所提出的RGB2LIDAR方法的优越性

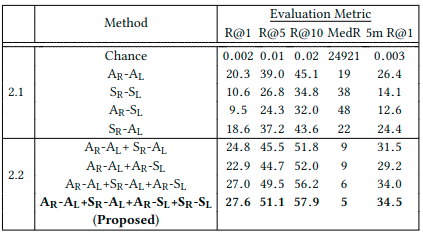

B. 消融实验

不同的组合策略,和上面的2.B相对应,显然是最后一种全面的策略效果最好。

C. LIDAR深度图的语义分割网络分析

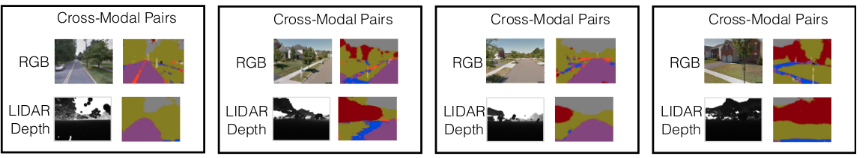

目前的对比结果是使用弱监督的跨模态语义分割网络的效果更好,但是作者认为组合小数据集的全监督在未来是一个更好的方向,图片是四个不同场景的弱监督跨模态语义分割可视化图。

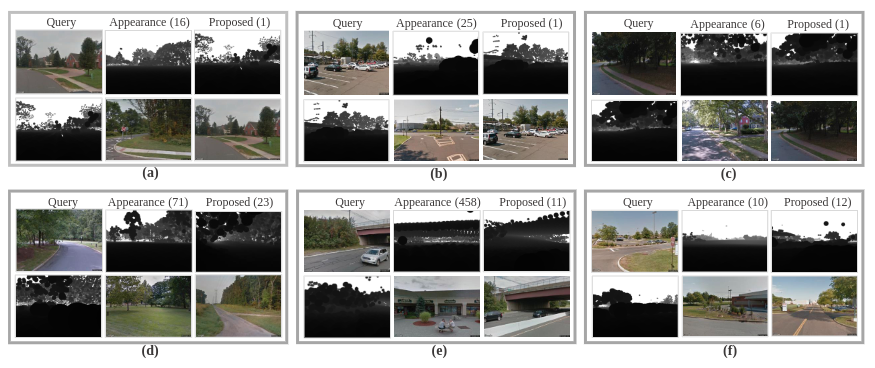

D. 和仅仅只有外观线索的方法的可视化比较

主要是说明这种融合的方式,可以捕捉到更加全面的信息

Conclusion

作者在这篇文章主要是提出了一种用于大规模跨模态视觉定位的方法。所提出的 RGB2LIDAR 利用在训练中自动收集的跨模态位置耦合对,并集成外观和语义信息进行高效检索。文章还建立了一个新的数据集 GRAL 来评估大规模跨模态视觉定位任务。

总的来说,这项工作的基本思想也可应用于将 RGB 图像与其他模态数据进行匹配以进行定位,例如来自其他传感器的 3D 点云、CAD 模型,毕竟在未来,多模态融合定位还是很重要的。

另外本文也有一些不足的是,本文主要是提供了一个融合的思路,并且证明了融合的有效性,但是对于融合的策略设置过于粗糙,比如说如何更好的设置语义和外观的融合策略可以产生更好的融合效果,这个有待深入研究。